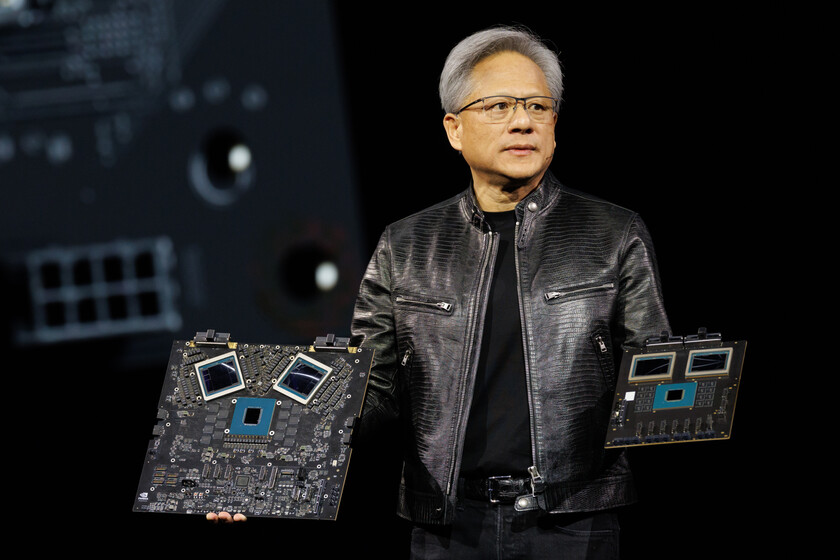

Cuando Nvidia presentó sus nuevos chips Ki, el B200 con arquitectura Blackwell, aprovechó la oportunidad para presentar un acelerador del GB200 llamado SO. Y al conectar 36 de estos aceleradores, el servidor AI creó el monstruoso DGX GB200 NVL72, que también lleva a cabo algunas sorpresas espectaculares.

Cada nudo es bestial. Cada uno de este acelerador GB200 tiene una CPU Nvidia Grace con 72 brazos -Neo -Neo -Nover V2 núcleos y con dos GPU B200. Al combinar su fuerza, tenemos una especie de GPU bestial con una salida de 1.44 exafultos en precisión FP4.

Un armario que pesa un quintal. La aparición del GB200 NVL72 DGX es la de un gabinete pequeño y estrecho que es sobre todo más denso: este estante pesa 1.36 toneladas. En el interior hay 18 nodos de computadora Bianca en un formato 1U, y todos tienen dos GB200 o lo que es lo mismo, con cuatro GPU B200 (por lo tanto, 18 x 4 = 72). Él Costos estimados De este servidor de IA son alrededor de tres millones.

El enfriamiento líquido es la clave. El calor derivado de estos componentes es notable, que en este caso es la mejor opción para enfriar estos elementos es el enfriamiento líquido. Este sistema se aplica no solo a la CPU -gnade o en las GPU B200, sino también en los chips NVLink de los interruptores, que también se pueden calentar mucho debido a la transmisión de datos masiva entre los aceleradores.

Conexiones en todas partes. Para que todas estas GPU puedan trabajar juntas, cada una de las 36 GB200 con tarjetas de red especiales tiene con ellas Soporte nvlink La quinta generación que permite que cada nodo de computadora esté conectado a otros. Hay nueve interruptores que proporcionan una gran cantidad de conexiones.

Cable de 3 km. Con el sistema puede disfrutar de un ancho de banda bidireccional de 1.8 TB/s entre el servidor 72. Pero como enfatizan En el registroLo realmente sorprendente es que hay un total de 3.2 kilómetros de cables de cobre en este «armario». Solo el módulo con el interruptor pesa más de 30 kilogramos debido a estos componentes y los más de 5,000 cables que se utilizan, de modo que todas las GPU de NVIDIA funcionan juntas y en una sincronicidad perfecta.

¿Por qué cobre? Puede ser extraño elegir cables de cobre, especialmente teniendo en cuenta las necesidades con respecto al ancho de banda impuesto por esta máquina. Sin embargo, la solución con cables de fibra óptica causó problemas claros: tendríamos que usar componentes electrónicos para estabilizar y convertir señales ópticas. Esto no solo habría aumentado los costos, sino también el consumo del sistema final.

¿Se puede funcionar con Crysis? El rendimiento de cada chips B200 ya es brutal: su rendimiento es triple que el de GeForce RTX 5090, y todo el servidor incluye 72 de este GPUSS especial para IA, lo que demuestra la capacidad de la computadora que tiene la máquina. También tiene núcleos RT (entrenamiento de rayos) de la cuarta generación, lo que teóricamente les permite usar estos chips de IA para jugar videojuegos, aunque, por supuesto, este ni siquiera es su propósito. De hecho, es probable que su desempeño en esta área Casi tan pobre como el Nvidia H100.

Consumo de nubes. Aunque los chips nuevos son mucho más eficientes que H100 -25 -Times menos, dice NVIDIA -Este servidor de IA tiene un TDP estimado de 140 kW. Desde el consumo promedio de una casa promedio en España redondo Los 3.000 kWh por año, en una hora después de usar el servidor NVIDIA, consumimos así como una casa española promedio en 17 días. Déjalo todo el año y parezca todo el año durante todo el año en España.

En | AMD tiene una gran hoja de ruta para sus chips AI. El problema todavía está en su software